05/09/2021 19:02

Vì sao Apple trì hoãn tính năng quét ảnh gây tranh cãi?

Apple gần đây đã công bố rất nhiều tính năng an toàn cho trẻ em cho iOS 15, bao gồm một công cụ tự động kiểm tra iPhone của bạn cho tài liệu lạm dụng tình dục trẻ em (hoặc CSAM).

Những công cụ như vậy thường được sử dụng trong các dịch vụ nhắn tin và lưu trữ đám mây, nhưng việc Apple thúc đẩy tính năng quét trên thiết bị đã dẫn đến phản hồi lớn trên mạng xã hội và báo chí. Do đó, Apple sẽ trì hoãn tất cả các tính năng an toàn cho trẻ em mới của mình.

Trong một tuyên bố gửi tới 9to5Mac, Apple cho biết họ "quyết định dành thêm thời gian trong những tháng tới để thu thập thông tin đầu vào và cải tiến” cho các tính năng an toàn cho trẻ em mới, cụ thể là máy quét CSAM.

Apple thừa nhận rằng “phản hồi từ khách hàng, nhóm vận động chính sách, nhà nghiên cứu và những người khác” đã dẫn đến sự thay đổi kế hoạch này.

Tuy nhiên, Apple tuyên bố rằng hệ thống quét CSAM của họ “được thiết kế với sự lưu ý đến quyền riêng tư của người dùng”. Trước khi ảnh của bạn được lưu trữ trong iCloud, iPhone của bạn sẽ cố gắng đối sánh chúng với cơ sở dữ liệu băm CSAM do NCMEC và các tổ chức an toàn trẻ em khác cung cấp.

Các hình ảnh phù hợp sau đó được lưu trữ trong iCloud với một “phiếu an toàn”, về cơ bản là một lá cờ vô hình mà chỉ Apple mới có thể theo dõi.

Nếu tài khoản iCloud của bạn chứa nhiều hình ảnh trùng khớp CSAM, thì Apple sẽ xem xét các hình ảnh đó theo cách thủ công. Những hình ảnh lạm dụng tình dục trẻ em được xác nhận sau đó sẽ được báo cáo cho NCMEC.

Apple nói rằng hệ thống này an toàn hơn các công nghệ quét chỉ trên đám mây, vì hình ảnh chỉ hiển thị với công ty nếu chúng được gắn cờ trước khi rời khỏi iPhone của bạn.

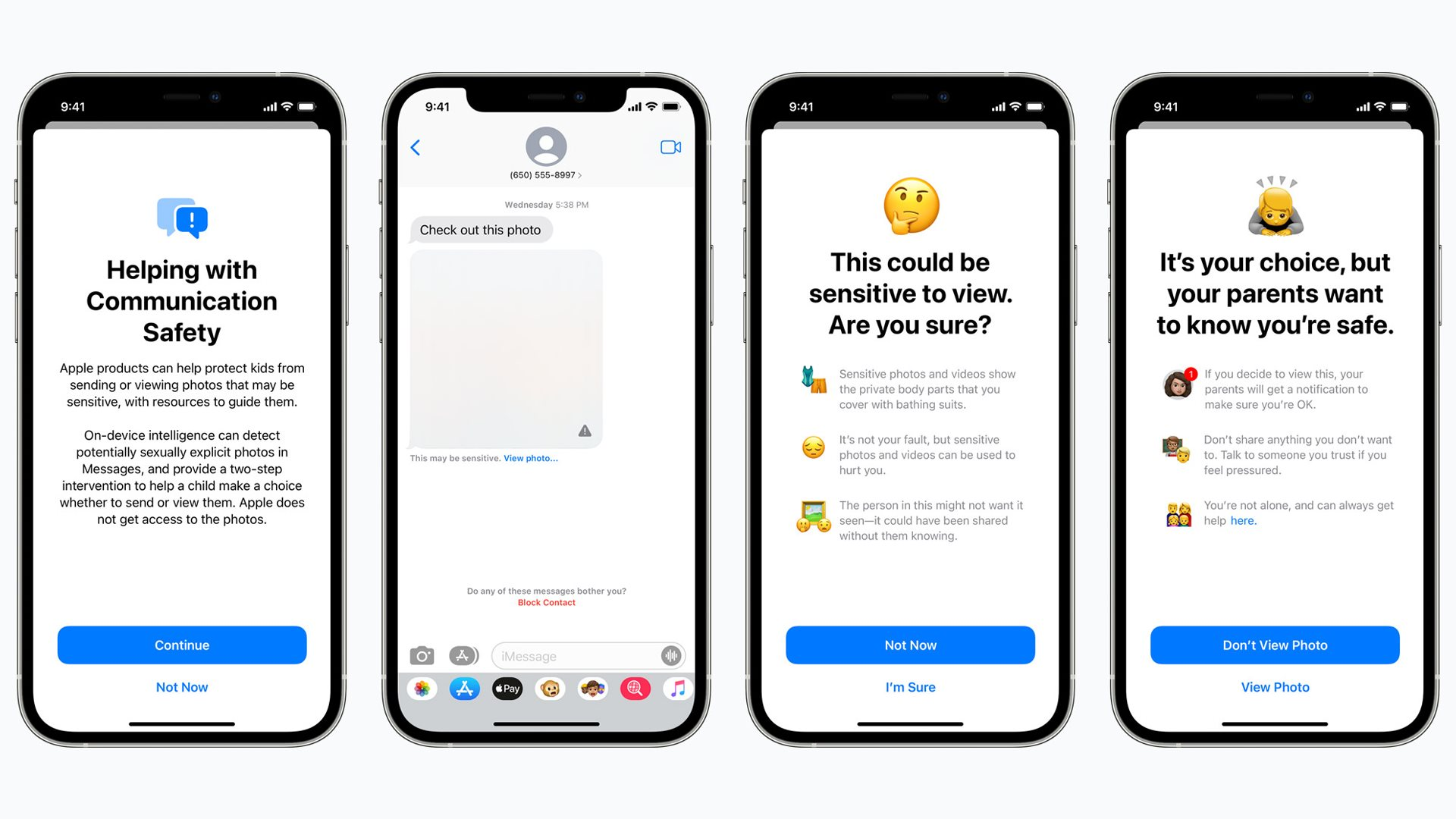

Một tính năng an toàn cho trẻ em đã được lên kế hoạch ẩn các hình ảnh khiêu dâm tiềm ẩn của trẻ em trong iMessage và cảnh báo cho phụ huynh nếu những hình ảnh đó được mở. Apple.

Nhưng những người ủng hộ quyền riêng tư lo lắng rằng máy quét CSAM của Apple sẽ bắt được thông tin xác thực giả, có khả năng để lộ hình ảnh riêng tư cho người lạ hoặc mở một cửa hậu cho các chính phủ và các tác nhân xấu. Công nghệ này cũng có thể tạo ra một tiền lệ xấu trong tương lai — liệu Apple có quét điện thoại để tìm ma túy hoặc các vấn đề khác mà cơ quan thực thi pháp luật có thể quan tâm không?

Chúng tôi vẫn chưa biết Apple có kế hoạch “cải thiện” Máy quét CSAM của nó. Nhưng thành thật mà nói, công ty có thể không mong đợi gặp bất kỳ phản ứng dữ dội nào ngay từ đầu.

Những tên tuổi lớn như Google đã sử dụng công nghệ CSAM trong các dịch vụ nhắn tin và đám mây của họ, đồng thời chính Apple cũng quét CSAM trong iCloud Mail.

Bất kể bạn đứng ở đâu, thật đáng thất vọng khi thấy Apple đẩy lùi một số công cụ an toàn cho trẻ em mới của mình , bao gồm tính năng Tin nhắn cảnh báo trẻ em không mở các tệp đính kèm ảnh hoặc video có khả năng khiêu dâm (nó không ngăn trẻ em mở các tệp đính kèm như vậy, nhưng cảnh báo cho cha mẹ nếu họ làm vậy).

Có thể những tính năng này sẽ ra mắt với những cải tiến về quyền riêng tư vài tháng sau iOS 15, nhưng một lần nữa, kế hoạch của Apple là rất rõ ràng.

Advertisement

Advertisement

Đọc tiếp